论文笔记-Addressing Some Limitations of Transformers with Feedback Mermory

这篇论文对Transformer的结构进行了反思,指出Transformer主要有两个缺点: 1. 对于Transformer的时序建模,虽然历史的高层信息已经被计算,但是这个信息并没有被充分利用; 2. 仅仅通过Attention和Feed forward模块,对时序信息建模的抽象程度不够。

基于这两个缺点,论文引入Feedback Memory模块。通过引入该模块,模型可以同时获得底层和高层的表示。该模型可以用更小更浅的模型取得sota效果。

模型

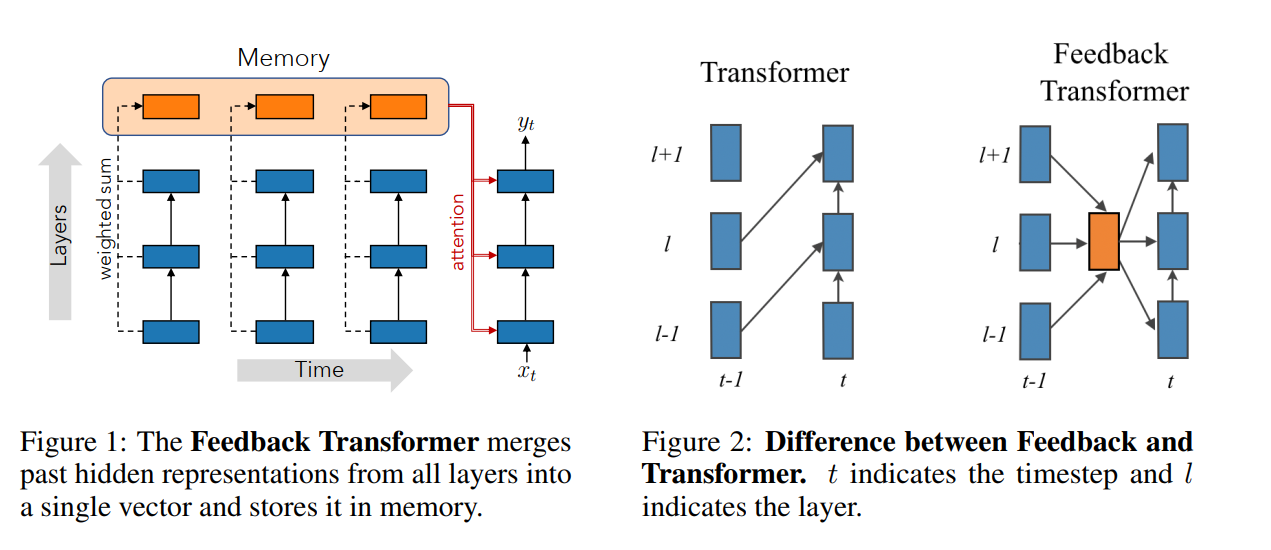

模型框架如图所示:

图1是模型的框架,创新点在于引入了memorty(橙色模块)。图2对比该模型与原始Transormer的区别。原始Transormer每个模块是通过Attn建模下层历史时刻和本是可的数据。可以看出模型通过引入了memory(橙色模块),橙色模块对历史所有层的信息建模,每个模块可以通过memory同时获得高层和低层的信息。

Transormer

Feedback Transformer

实验结果

模型改动比较小,这样改动之后。模型训练时就不能并行训练了。所以,除了实验结果,训练时间也是一个比较关注的问题。

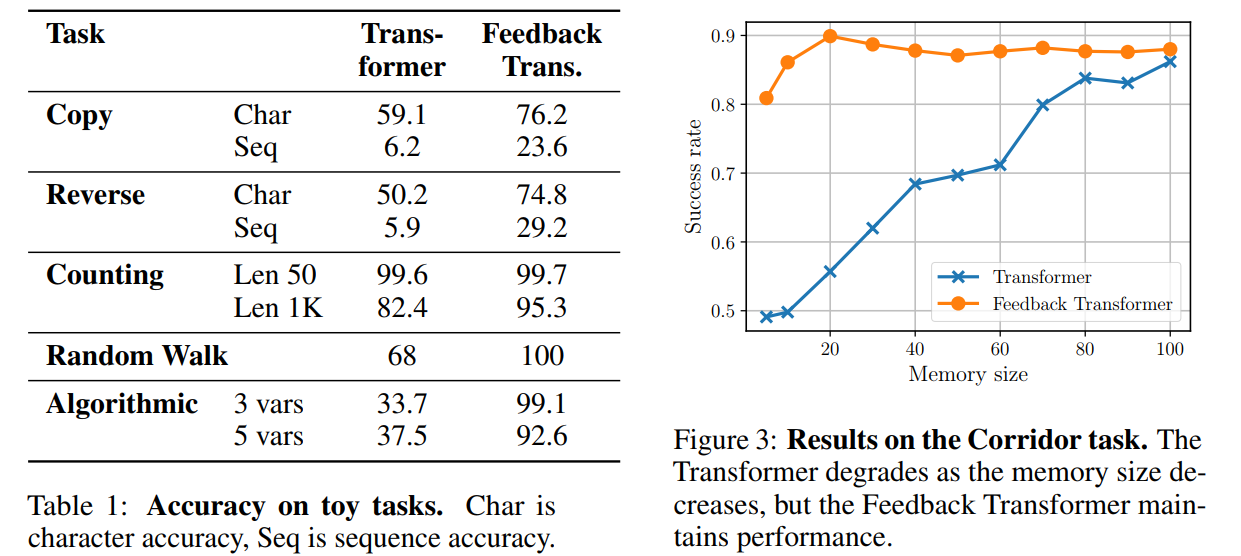

其中Fig3.和Tab1中的Copy,Reverse, Counting任务与长期记忆相关。对比可以发现,这篇论文的方法比原始Transormer有明显提升。并且在小模型下,提升更明显,且增大模型模型的结果依然很稳定。

Tab1中的Random Walk和Algorithmic任务测试模型的状态更新能力,可以发现改论文的方法依然优势很强。

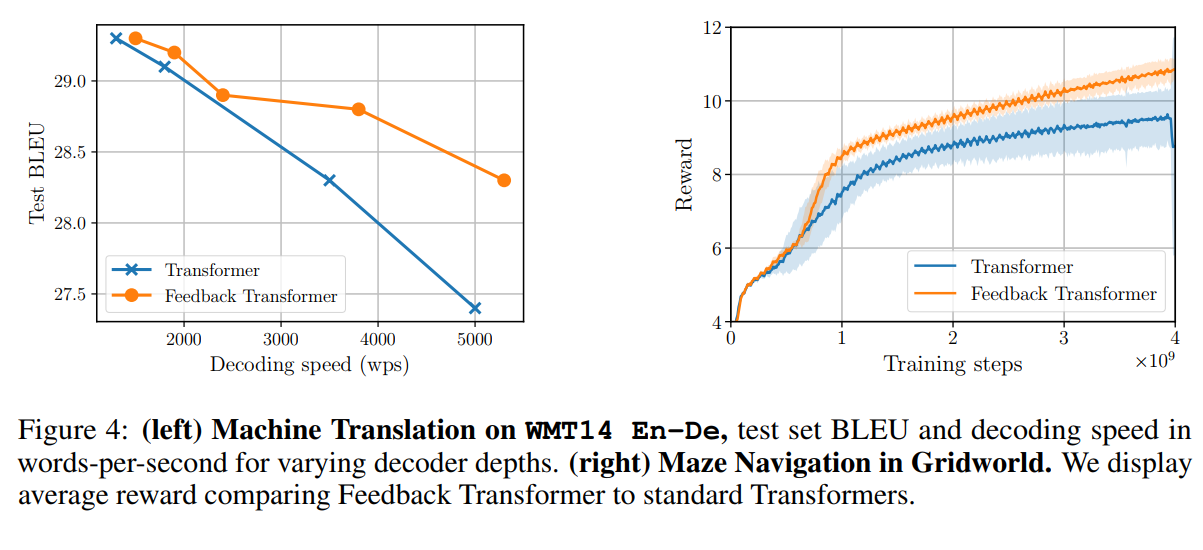

左图与Fig3的结论类似,模型在小模型下就可以有很好的效果。右图依然是在证明模型的状态更新能力。

该论文与目前常见的时序模型进行对比(RNN,RNN+Attn,Transformer三种结构),可以发现该论文提出的模型框架比其他结构都有更好的实验效果。

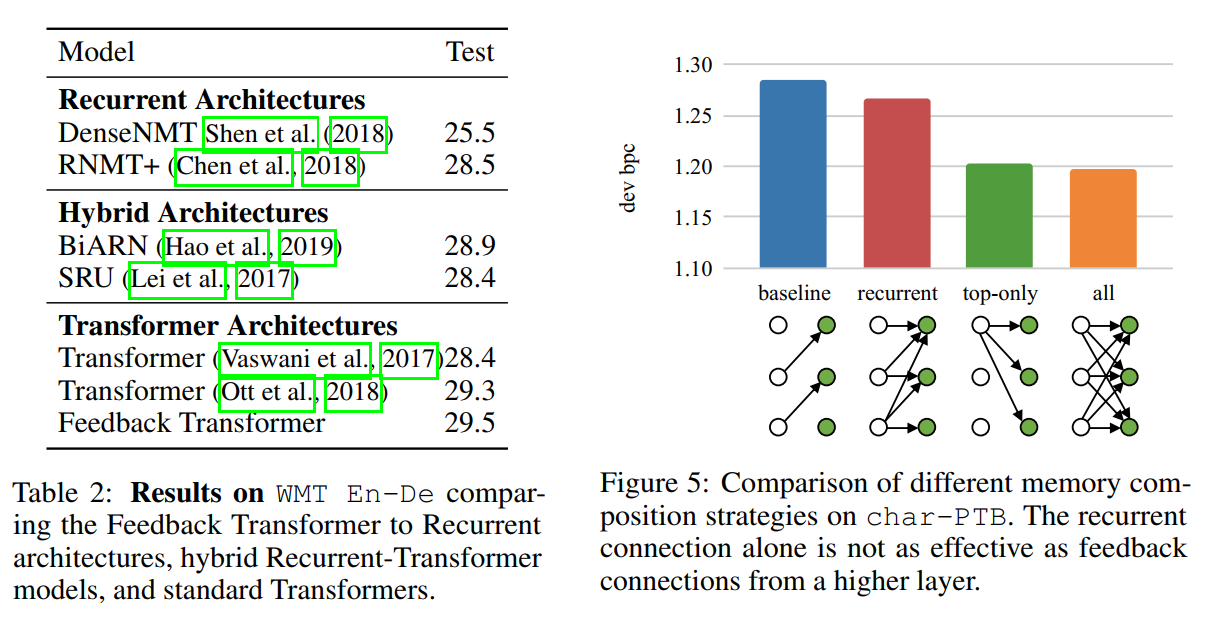

Fig5可以看出,引入Memory实质是更改了Transformer的拓扑结构,改论文提升实验效果的原因是使用了更复杂的拓扑结构。

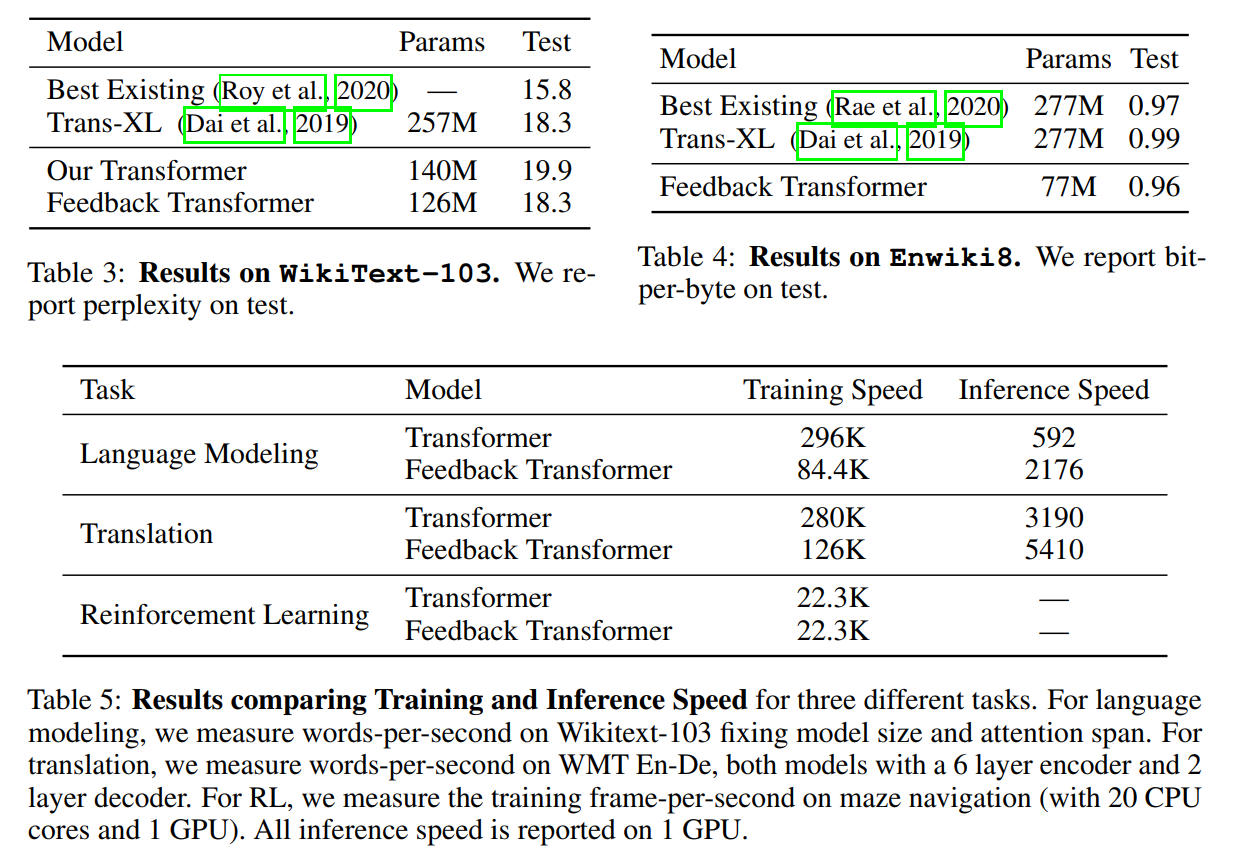

该论文也使用了一些技巧来提升模型的速度。在常见的数据集上与Transformer进行了对比。发现模型可以用更小的参数量,在不降低实验效果的情况下比其他模型有更快的训练和推理速度。

结论

这篇论文相对比较简单,就是在原始模型上加了一个Memory模块。但是做了比较充分的实验,确实验证了实验效果还不错。